Nem titok: az elmúlt években a deepfake technológia meglehetősen kétes hírnevet szerzett magának. A hihetetlenül valósághű videói és hangutánzásai a legéberebb szakértőket is képesek voltak időnként megtéveszteni. A deepfake-ben fejlett mesterséges intelligenciát használnak arra, hogy arcokat és emberi beszédet helyezzenek el egy-egy videón úgy, hogy azok teljesen hitelesnek tűnjenek. Bár maga a technológia első pillantásra lenyűgöző, komoly aggodalmakat vet fel a benne rejlő visszaélések lehetősége miatt.

A „mélyhamisítás” kifejezés 2017-ben jelent meg, amikor egy Reddit-felhasználó „deepfakes” álnéven mesterséges intelligencia technikák segítségével manipulált videókat kezdett el publikálni. Az első vírusos deepfake-ek között olyan explicit videók is szerepeltek, melyekben ismert hollywoodi színésznők arcát más emberek képével helyettesítették.

Az egész jelenség az érdeklődés és aggodalom hullámát váltotta ki rögvest, felvetve az MI-technológia felelősségét is lehetőségeivel kapcsolatban.

E technológiák mára már lehetővé teszik olyan képek és videók létrehozását is, melyeket egyre nehezebben tudunk csak megkülönböztetni a valódiaktól. A technológia fejlődésével párhuzamosan a készítésének eszközeihez való könnyebb hozzáférhetőség is egyszerűsödött, így a mélyhamisítások technikai ismeretével eleve nem rendelkező felhasználók is ma már könnyedén képesek deepfake „műalkotásokat” létrehozni egy-egy szoftverrel.

Hogyan működnek a mélyhamisítások?

A deepfake létrehozása így ma már nem ördöngösség, csupán valamilyen fejlettebb mesterséges intelligencia technológiára van hozzá szükségünk. Íme azért laikusoknak a folyamat egyszerűsített magyarázata:

- Mélytanulás és neurális hálózatok: A deepfake a mélytanuláson alapul, a mesterséges intelligencia egy olyan ágán, ami az emberi agyhoz hasonló „virtuális” neurális hálózatokat használ. Ezek nagy mennyiségű adaton tanulnak és képesek összetett problémákat is megoldani. A deepfake esetében viszont eleve már arra képzik ki őket, hogy a videókon és képeken szereplő arcokat sikeresen manipulálják.

- Variációs autókódolók (VAE): A mélyhamisítások létrehozásában az egyik másik gyakran használt technika a variációs autokódoló (VAE) bevetése. Ezek olyan neurális hálózatok, melyek a bemeneti adatokat (jelen esetben az arcokat), alacsonyabb dimenziós „látens térbe” kódolják és tömörítik. Ezután képesek csak rekonstruálni ezeket a látens reprezentációkból, új képeket generálva a betanult jellemzőik alapján.

- Generatív adverzális hálózatok (GAN-ok): A tökéletesebb realizmus elérése érdekében a mélyhamisítók generatív adverzális hálózatokat (GAN-okat) is használ(hat)nak. Ezek két neurális hálózatból állnak: egy generátorból és egy diszkriminátorból. A generátor hamis képeket hoz létre a látens reprezentációból, míg a diszkriminátor értékeli e képek hitelességét. Az első célja, hogy olyan valósághű képeket hozzon létre, melyeket a diszkriminátor már nem tud megkülönböztetni a valós képektől.

A deepfake alkalmazásai

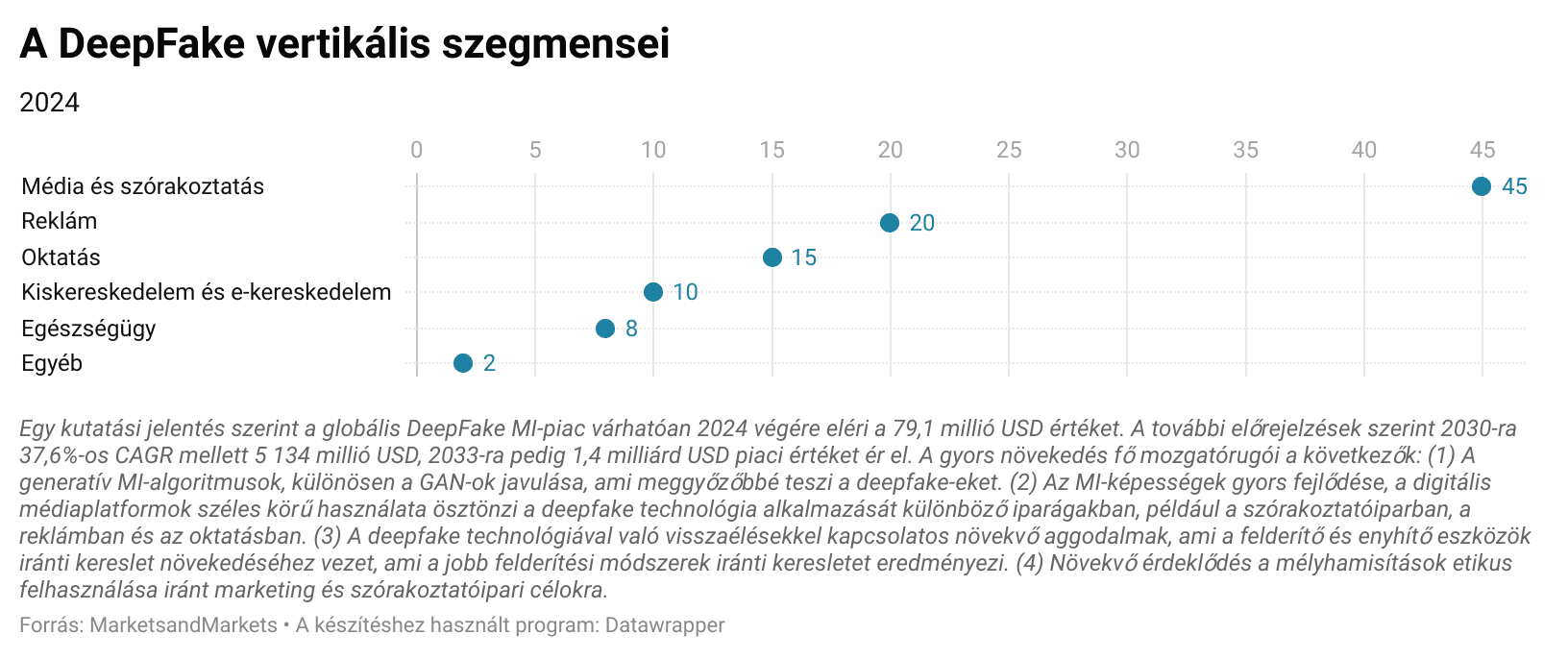

A deepfake alkalmazások széles skálája elérhető már, ezek lehetnek pozitívak és negatívak is egyaránt.

- Szórakoztatás: A filmekben és a televízióban a deepfake-ek megfiatalítják a színészeket, életre kelt(het)ik az elhunyt karaktereket, vagy akár veszélyes jelenetekben kaszkadőrök helyett is bevethetők. Figyelemre méltó példa erre a fiatal Leia hercegnő újjáalakítása a „Zsivány Egyes: Egy Star Wars-történet”-ben, amikor Carrie Fisher arcát egy másik színésznőre helyezték.

- Oktatás és művészet: A mélyhamisítványok értékes eszközök lehetnek interaktív oktatási tartalmak létrehozásához is, lehetővé téve a halott történelmi személyek életre keltését és így múltbeli események látványos elmesélését. A művészetben innovatív alkotások készíthetők történelmi stílusok és technikák ötvözésével.

- Marketing és reklám: A vállalatok a deepfake segítségével személyre szabhatják a hirdetéseiket és a marketing tartalmaikat, növelve a közönségük elkötelezettségét. Képzeljünk el egy olyan reklámot például, melynek főszereplője a mi digitális ikertestvérünk lenne.

- Orvostudomány: Az orvostudomány területén a deepfake-ek oktatási célokra orvosi eljárások szimulációit hozhatják létre, segítve a medikusokat a sebészeti technikák szemléltetésében és gyakorlásában.

Kockázatok és problémás adaptációk

Pozitív alkalmazásaik ellenére a deepfake-ek jelentős kockázatokat hordoz(hat)nak. Az egyik legsúlyosabb probléma ma, a technológia kezdetén még mindig a rosszindulatú felhasználásuk lehetősége.

- Félretájékoztatás és álhírek: A mélyhamisítványok könnyedén felhasználhatók a közszereplőkről készült hamis videók készítésére, téves vagy manipulált információk terjesztésére. Ez befolyásolhatja a közvéleményt, a választásokat és társadalmi káoszt okozhat.

- Személyazonosság-lopás és az adatvédelem megsértése: A mélyhamisítványok felhasználhatók tiltott (akaratuk ellenére létrehozott) pornográf tartalmak létrehozására, a közösségi médiában személyek megszemélyesítésére vagy pénzügyi csalás elkövetésére is. Ezek a felhasználások érzelmi és gazdasági károkat okozhatnak az áldozatoknak és környezetüknek.

- A digitális tartalmakba vetett bizalom aláásása: Ahogy a mélyhamisítványok egyre valósághűbbé válnak az idő folyamán, úgy egyre nehezebb lesz majd megkülönböztetni a valódi és a hamisított tartalmakat. Ez alááshatja a digitális médiába és a vizuális információhordozókba, mint bizonyítékokba vetett bizalmunkat.

A mélyhamisítások felismerése

A mélyhamisítások felderítése ma még nagy kihívást jelenthet, de számos stratégia és eszköz segíthet a felismerésükben:

- Arcfelismerési anomáliák: Keressünk olyan részleteket, mint a szokatlan mozdulatok, a szabálytalan pislogás vagy az arckifejezés olyan megváltozásai, melyek nem illenek az adott kontextusokba. A túlságosan tökéletes vagy akár mesterségesnek tűnő bőr szintén jel lehet erre.

- A bőr textúrája és tükröződései: Vizsgáljuk meg a bőr textúráját és bármilyen tükröződés jelenlétét. A mélyhamisítványok gyakran nem tudják pontosan reprodukálni ezeket az apró és finom részleteket, különösen a szemüvegek vagy az arcszőrzet jelenléte esetében.

- Érzékelési eszközök: Szerencsére ma már vannak „gyári” speciális eszközök a deepfake felismerésére. Ezek a szoftverek szintén mesterséges intelligencia-algoritmusokat használnak a videók elemzésére és hitelességük megállapítására.

Tartalommarketing és SEO

A mélyhamisítások jelentős hatással vannak a tartalommarketingre és a SEO-ra, pozitív és negatív irányban egyaránt:

- Hitelesség és hírnév: A mélyhamisítások könnyedén alááshatják egy márka hitelességét, ha direkt eleve hamis hírek és félrevezető tartalmak létrehozására használják őket. A hitelesnek tűnő, bár hamis videók terjesztése súlyosan befolyásolhatja egy-egy vállalat nehezen megszerzett hírnevét.

- Márkavédelem: A vállalatok a mélyhamisítványokat a személyazonosság-lopások felderítésére és leküzdésére is bevethetik. A márkát megszemélyesíteni próbáló hamis profilok azonosításával proaktív intézkedéseket tehetnek hírnevük és a keresési eredményekben elfoglalt pozíciójuk sikeres és eredményes védelme érdekében.

- SEO-optimalizálás: A deepfakes kreatív és jogszerű használata feljavít(hat)ja a multimédiás tartalmakat, vonzóbbá és könnyebben megoszthatóbbá téve azokat a social media-ban. Ez javíthatja a webhelyen való tartózkodási időt is és csökkentheti a visszafordulási arányokat (bounce rate) egyben, melyek fontos tényezők ma mindenki számára a SEO szempontjából.

Több organikus látogatót szeretnél a weboldaladon?

Bízd ránk a keresőoptimalizálást A-tól Z-ig!

Minden SEO feladatot késlekedés nélkül, magas minőségben végzünk az InternetSolutions Kft.-nél a SEO audittól a stratégiakészítésen és tanácsadáson át a SEO tartalomfejlesztésig, akár AI támogatással. Írj egy üzenetet, és rövidesen felvesszük veled a kapcsolatot!

"*" a kötelező mezőket jelöli